本文只代表我自己的不成熟的思考,请勿过度解读。

试想如下两个场景。

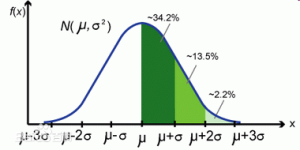

- 场景一:我们做了一个随机试验(random experiment),通过各种实验数据分析我们得出了结论是ATE(平均效果)为1%的提升,对应的p-value是0.09。所以这个东西10%显著,应该推广。

- 场景二:我是一个风险投资者,我现在有100个项目可以投或者不投,每个项目都有其预期收益和对应的风险。我需要通过各种投资组合实现收益的最大化。

正常的来讲,上面两个场景分属于两个领域:实验分析和金融投资分析。好像之间并没有太大的关系。如果大家做实验分析就知道,大部分paper关心的都是如何得到一个干净的average treatment effect estimate,哪怕是为了降低variance做一些variance和consistency之间的trade-off,我也是在大原则不变的情况下。第二类文献我不是特别熟,但是通过有限的金融投资学的知识,我大概知道做法就是一个线性或者非线性、随机或者非随机(这里的随机是stochastic而不是random)的最优化过程、关注的更多是一些本身不可控的因素。

可是为什么我突然把这两者放在一起?今天突然讨论起type i 和type ii error,然后就不自主的联系到decision making...然后突然间觉得好像有哪里不对...互联网公司大家特别特别的依赖a/b test,一方面是谁也不知道什么是正确的所以索性让数字来说话,另一方面也是有点过度相信统计学的权威、依赖各种统计量和统计模型——我并不是说我们应该剥夺这种权威,而是有的时候好像忘了为什么一开始我们需要引入这样的决策体系。

先说一下我所熟悉的决策体系:做一个a/b test,如果实验结果显著为正(就像大部分field experiment那样),我们就给予实验者相应的奖励(towards business goal)、然后整个铺开。从机制设计的角度,这是一个有效的机制:规则是透明的也是保证正收益的,每个组都在这个机制下play the game是相对公平的。可是这样的机制的缺点是什么...无数的analyst就一夜夜的浪费脑细胞在获得一个可以被认可、又可以最大化自己所属团队贡献的估计量。business side只关心那个估计量的大小,然后公司内部的裁判角色又来审查你这样做是不是统计上正确的。所以many companies end up with a group of data scientists。

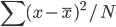

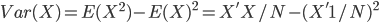

可是我们好像忘了一个东西:efficiency。公平是公平了,但是这个机制是效率角度最优的么?从公司的角度,做这么多a/b test实际上就相当于一个投资组合的决策过程:我需要在哪些上面投入更多、哪些上面投入不要这么多。每一种决策都是有风险的,那么既然是一个风险和收益的最优化过程,我就应该计算所有预期收益、成本和量化风险。风险应该是一个连续的度量而不是一个简单如p-value <10%这样1或0的二维决策过程。

所以说到这里,其实当你在做那么多实验的时候,其实那些针对单个实验分析的指标甚至理论什么的就不重要的。每一个都做到极致并不代表整体是最优化的,甚至可能是囚徒困境那般谁都走不出去?suddenly I got very sick talking about type I and type II errors. I don't think that fits the culture.

大概就是这些,最近脑子里面萦绕的就是这样稀奇古怪的想法...喵。

bottom line

想起来一个joke: statisticians are good at generalizing stuffs (when we talk about statistical tools....the answer is it does not matter! because you should be good at generalization.)